Wie Chatbots die Data-Science-Welt verändern

Data Science Trends

Die Einen sehen sie als Teil eines Trends, der schon wieder vorbei ist, bei den Anderen sind sie noch gar nicht angekommen. Spätestens wenn Sie bei der Hotline Ihres Telefon-Anbieters anrufen, werden auch Sie vermutlich mit Ihnen in Berührung kommen: mit den Chatbots.

Im April 2017 gab es alleine bei Facebook und für Alexa geschätzte 125.000 Chatbots. Technologie-Prognosen sagen im Bereich Kundenservices einen Anstieg der Verbreitung von 2% im Jahr 2017 auf 25% im Jahr 2020 voraus.

Nach dem wir zuletzt beschrieben haben, was Chatbots sind und welchen Nutzen sie haben (Teil 1), werfen wir heute einen Blick auf die Veränderungen, die sie im Bereich von Software und Daten mit sich bringen.

Einfache Bediener-Interfaces

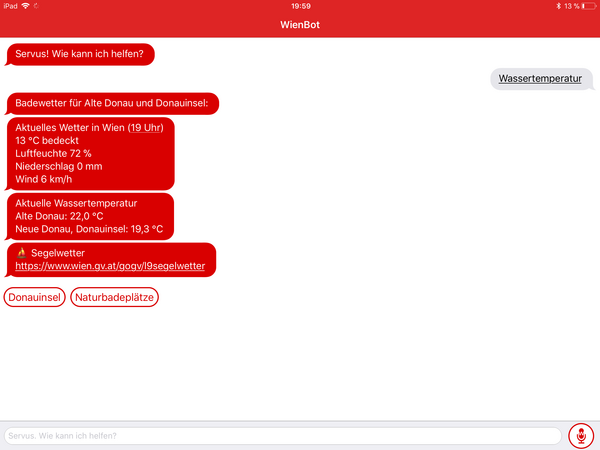

Die Schnittstelle für den Benutzer von Chatbots ist sehr einfach gehalten. Durch den Einsatz von Natural Language Processing (NLP) kann die Kommunikation mittels Mikrofon und Lautsprecher erfolgen. Die Herausforderung dabei ist die Echtzeit-Analyse der menschlichen Sprache und die Zerlegung des Inhalts in eine für das System verständliche Form (semantische Zerlegung). Dazu können, abhängig vom verwendeten Gerät, Siri, Cortana, Alexa & Co. verwendet werden. Auch IBM bietet mit Watson eine cloudbasierte Möglichkeit, die unabhängig vom Gerät funktioniert.

Zusätzlich zur Spracheingabe sollte auch eine einfache Chat-Oberfläche die Kommunikation unterstützen. So sieht der Anwender auch, ob seine Frage richtig verstanden wurde und kann in lauter Umgebung auch per Chat mit dem System kommunizieren.

Für die Software-Entwicklung stecken die Herausforderungen also weniger in der Entwicklung der Oberfläche, sondern eher an der schnellen und fehlertoleranten Verarbeitung der Eingangsdaten.

Lernendes System

Enorme Bedeutung hat die optimale Umsetzung der Lernfähigkeit des Systems. Von kleinen Ergänzungen um weitere Datensätze, die sich aus neuen Anfragen ergeben, bis zur Ableitung neuer Regeln und Assoziationen aus längere Zeit beobachtetem Benutzerverhalten ergibt sich je nach Komplexität eine große Bandbreite, das System lernfähig zu machen. Der „Lernfaktor“ des Systems ist höher, wenn das System selbst die Fragen stellt und aus den Antworten neue Regeln und Assoziationen lernt. Heutige Chatbots lernen oft noch sehr statisch und haben dadurch oft erhöhten Bedarf an Anpassungen und Betreuung.

Ist die Antwort aber nicht aus dem „Wissen“ des Systems zu ermitteln, kann das System den Benutzer um bessere Erklärung oder andere Formulierung ersuchen oder auf den Servicedienst verweisen – der Mensch übernimmt den Fall.

Gut strukturierte Daten

Um entsprechende Antwortzeiten zu ermöglichen, werden alle erhaltenen Fragen aufgezeichnet und im Nachhinein gelernt. Auch hier spielt der Mensch eine wichtige Rolle, um die Richtigkeit der identifizierten Regeln und Daten zu bestätigen.

Gerade in der Phase nach der Einführung des Chatbots ist es also wichtig, ausreichend Ressourcen für die Erweiterung des Systems im Bereich Daten und Lernen zur Verfügung zu haben, damit der Chatbot sein Potential entfalten kann. Die Strukturierung und effiziente Ablage der Daten z. B. in einem Data Warehouse ist ein wichtiger Schritt zum Erfolg.

Fazit

Der Trend zum Einsatz künstlicher Intelligenz erfordert die bessere Strukturierung von Daten um diese performant bereitstellen zu können. Bestehendes Wissen in ein lernendes System zu verpacken und den BenutzerInnen eine möglichst einfache Schnittstelle zur Verfügung zu stellen, sind die Herausforderungen der Zukunft – in vielen Fällen kann ein Chatbot die Antwort sein.

Wann sind die Veränderungen für die Data Science-Welt enorm groß? …

- wenn das Lernen im System noch nicht umgesetzt wurde

- dort, wo Prozesse erst analysiert, beschrieben und digitalisiert werden müssen

Wenn Sie an die Entwicklung eines lernenden Systems oder einen Chatbot denken, wenden Sie sich gerne an uns!

Autor: Gerald Holzbauer